Egal ob SmartHome-Systeme, Gesichtserkennung auf dem Handy, Fahrassistenzsysteme im Auto oder Suchvorschläge bei Google und Netflix: Künstliche Intelligenz (KI) beeinflusst längst unseren Alltag. Aktuell gibt es einen riesigen Hype um KI-Tools wie „ChatGPT“ oder „Midjourney“. Mit ihnen kann man einzigartige Texte und Bilder erstellen und das mit nur kurzen Sprachbefehlen.

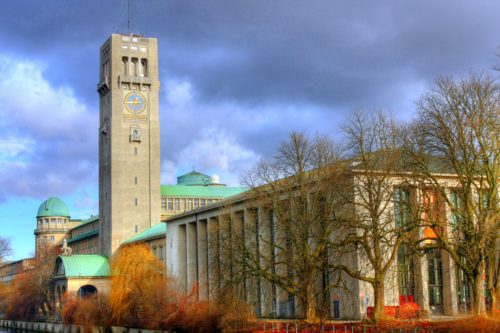

Foto: Ansicht des Erdklimas von oben. Credits: pixaby/WikiImages.

Doch nicht nur in den Medien und der Gesellschaft sind die Erwartungen an die KI groß, sondern auch in der Forschung. In den Klimawissenschaften werden immer mehr Forschungsarbeiten veröffentlicht, in denen die Autoren Künstliche Intelligenz eingesetzt haben. Auch von „Maschinellem Lernen“, „Deep Learning“ und „Big Data“ wird immer häufiger gesprochen. Bringt die Technologie die Klimaforschung wirklich voran?

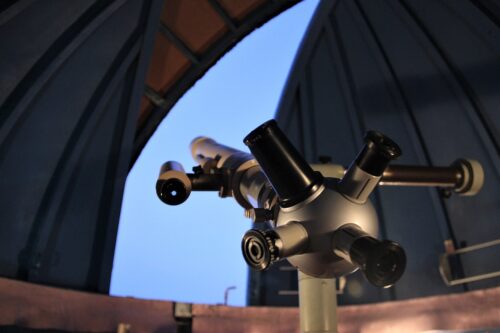

Mit Supercomputern und KI das Klima vorhersagen

In der Klimawissenschaft wird KI vor allem eingesetzt, um das Klima in ferner Zukunft vorherzusagen. Bei der Klimamodellierung fließen Naturgesetze aus der Physik als mathematische Formeln in Gleichungen ein. Bei der Physik gibt es jedoch viele Prozesse und Wechselwirkungen, die berücksichtigt werden müssen. Das macht es den Forschern unmöglich, diese Gleichungen zu lösen. Supercomputer und KI helfen, diese zumindest näherungsweise zu entschlüsseln. Die wichtigsten Grundlagen dafür sind große Datenmengen und viel Rechenleistung. Beides bietet das deutsche Klimarechenzentrum (DKRZ) in Hamburg. Die Forschungsgruppe „Climate Informatics and Technologies“ am DKRZ hilft den Forschern, Klima- und KI-Wissenschaft besser zu verknüpfen. Leiter der Projektgruppe ist Dr. Christopher Kadow.

Kadow sagt: „Der Begriff KI wird definitiv falsch und zu häufig verwendet“, auch in der Forschung: „Weil es so ein allgemeingültiges Wort geworden ist. Aber eigentlich machen alle, die maschinelles Lernen oder die, die neuronale Netze benutzen, Deep Learning.“ Mit maschinellem Lernen und Deep Learning bezeichnen Fachleute wie Kadow verschiedene Bereiche Künstlicher Intelligenz.

Eine Form des maschinellen Lernens sind künstliche neuronale Netze. Diese sind an das menschliche Gehirn angelehnt und werden eingesetzt, um zum Beispiel Gewitterwolken zu erkennen. Die Input-Daten (Fotos oder Sensorenmesswerte) werden an eine Schicht von inneren Neuronen geschickt. Bei jedem inneren Neuron gibt es eine klare Regel (Ist das Objekt grau?). Das Ergebnis (Es ist grau!) entscheidet, zu welchem Neuron die Daten weitergeleitet werden. Das können entweder die Output-Neuronen sein, bei dem das Ergebnis (Gewitterwolke!) mitgeteilt wird oder eine weitere Schicht von Neuronen mit neuen Regeln (Schwebt die Wolke unter einer Höhe von 2000 Kilometern?). Besitzen neuronale Netze mehrere dieser Schichten, nennt man es Deep Learning. Deep Learning eignet sich sehr gut für große Datenmengen. Dadurch, dass viele Entscheidungen nacheinander getroffen werden, ist aber mitunter nicht klar, wie ein konkretes Ergebnis zustande gekommen ist.

Höher, schneller, weiter – Die Vorteile von KI

KI kann sehr schnell Zusammenhänge erkennen, wo Menschen oft lange Zeit benötigen. Das ist gerade in der Klimawissenschaft, wo es um sehr komplexe Vorgänge geht, ein Vorteil. Außerdem können die Forscher mit KI eine höhere Anzahl an Modellen berechnen. „Man macht nicht nur eine Vorhersage, sondern 100 oder am besten 1000 und bildet den Mittelwert“, erklärt Kadow. Denn gerade bei Vorgängen, die weit in der Zukunft liegen, gibt es nicht die eine wahre Vorhersage. „In der Verteilung des Ganzen ist es ganz gut. Aber die tatsächliche Wahrheit zu treffen, ist sehr schwierig.“

Mit der Zeit werden die Klimamodelle immer genauer. Wobei manche Parameter, die über große Gebiete ähnlich sind, wie beispielsweise die Temperatur am genauesten modelliert werden können. „Da würde ich sagen, sind wir im einstelligen Grad Celsius Bereich“, schätzt Kadow. Schwieriger sei es hingegen bei spontan auftretenden, lokalen Ereignissen wie Regen oder Gewitter: „Das ist so etwas wie der heilige Gral, diese Ereignisse genau zu modellieren.“

In den nächsten Jahren soll die KI vor allem dabei helfen, noch präzisere Vorhersagen zu treffen. Ziel sei laut Kadow eine die globalen Veränderungen bis auf einen Kilometer genau zu modellieren und das Wetter für die nächsten Wochen, Monate und Jahre genauer vorherzusagen. Auch an der Geschwindigkeit der Vorhersagen werde noch geforscht, um zum Beispiel vor Naturkatastrophen in wenigen Sekunden warnen zu können. „Das wird man spüren. Da werden gewisse Dinge deutlich besser werden, die dann auch in der Wirtschaft wahrgenommen werden.“

Alte Modelle im neuen Gewand

Für den aktuellen KI-Boom sind aber nicht die KI oder Physik selbst verantwortlich. Im Gegenteil, die physikalischen Grundmodelle gab es schon vor mehr als 50 Jahren. Auch die Ideen, mit denen KI-Modelle funktionieren, sind schon alt. Die Methode der kleinsten Quadrate, mit der die Fehler der Modelle berechnet werden, entwickelte Carl Friedrich Gauß bereits 1795. Der aktuelle Fortschritt liegt in drei anderen Bereichen.

Erstens gibt es mehr Möglichkeiten, Daten zu erheben, zum Beispiel über Sensoren. Dazu können heute deutlich mehr Daten gespeichert werden. Levante, der Supercomputer des DKRZ, speichert über 800 Terabyte Daten.

Zweitens können diese vielen Beobachtungsdaten erst seit einiger Zeit sinnvoll verwertet werden. Früher habe man die Wettermodelle nur eingeschränkt laufen gelassen, so Kadow. „Nicht, weil wir nicht wussten, wie die Physik funktioniert, sondern weil die Computer es gar nicht konnten.“ Da die Computerleistung jetzt deutlich verbessert wurde, kann man mehr Daten einfließen lassen. „Hätten wir die heutigen Prozessoren bereits in den 90ern gehabt, dann wären wir damals schon deutlich erfolgreicher gewesen.“

Die dritte Veränderung betrifft die Anwendung von KI-Systemen. Sie ist viel einfacher geworden. „Und ich glaube, dass die junge Generation das gerade schon sehr gut ausnutzt“, findet Kadow. Doch die einfache Anwendung drohe zur Gefahr zu werden, wenn Forscher sie nutzen, ohne ihre Beschränkungen zu verstehen. „Das blinde Anwenden ist so einfach geworden, dass sehr viele an der eigentlichen Aufgabe vorbeischießen“, kritisiert Kadow. Gute Daten sind die wichtigste Grundlage, denn die Modelle können schließlich immer nur so gut sein, wie ihre Trainingsdaten. „Garbage in, garbage out“ – „Müll rein, Müll raus“ sagen die Statistiker gerne. Wenn die Daten schlecht sind, helfen auch Modelle, die sich perfekt an diese Daten anpassen, nicht.

Lieber etwas langsamer, aber dafür stimmt es

Ein weiteres Problem bei der Nutzung von KI ist die Fokussierung auf ein einziges Problem, wie zum Beispiel: Wie wahrscheinlich gewittert es in meiner Stadt? „Da sind die Modelle relativ schlau. Nimmt man dasselbe Programm für eine andere Fragestellung, ist es sehr dumm, weil es nicht allgemeingültig ist.“ Das Problem der Spezialisierung betreffe aber nicht nur die KI, sondern auch die Forscher selbst: „Die Leute lernen häufig mit einem Tool zu arbeiten und werden da häufig auch ziemlich gut drin. Aber sie denken dann, dass sie diese Tools auch auf alles andere anwenden können.“

Was in Zukunft noch alles mit KI in der Klimaforschung möglich sein wird, hängt vor allem davon ab, was wie schnell aus der Informatik adaptiert werden kann. „In der Klimaforschung ist man ein bisschen konservativer, was auch gut ist, weil es immer richtig sein muss. Das heißt aber, den Schwung, den wir jetzt erleben, gab es in der Informatik schon vor fünf Jahren“, erklärt Kadow.