Der kleine türkisfarbene Pinguin hat Verständnis für meine intimsten Gedanken. „Wir können das ein anderes Mal machen, wenn du dazu bereit bist.“ Eine weitere Sprechblase erscheint und kündigt eine neue Nachricht des virtuellen Vogels an. „Ich bin für dich da.“ Was ungewöhnlich erscheint, ist keine Seltenheit in Europa. Und die Entwicklung solcher Chats geht weiter – vor allem in Portugal.

Foto: KI generiertes Bild nach der Eingabeaufforderung „Male ein abstraktes Bild zum Thema KI in der Psychotherapie!“ Credits: OpenAI.

Portugal liegt auf Platz 1 in der EU, wenn es um die Häufigkeit von chronischen Depressionen bei Frauen geht. Das geht aus Angaben der portugiesischen Gesellschaft für Psychiatrie und psychische Gesundheit (SPPSM) ebenso hervor wie aus Daten des statistischen Amts der Europäischen Union (Eurostat). Auch mit der Prävalenz von psychischen Erkrankungen allgemein sieht es nicht besser aus: Platz 2. Gleichzeitig gibt es – wie fast überall auf der Welt – nicht genügend Therapieplätze. Betroffene warten oft ein halbes Jahr darauf.

Zu lange, findet Francisco Valente Gonçalves. Der Diplom-Psychologe aus Portugal promovierte mit einem von der Europäischen Kommission geförderten Marie-Curie-Stipendium in Kriminologie und Psychologie. Und er ist Gründer von Rumo, einer internationalen Plattform für Online-Therapie. Sie soll den Zugang demokratisieren: Therapie günstiger und überall, lautet das Versprechen. Nun will er noch weiter gehen. Wenn wir Chat GTP Grußkarten schreiben und Matheaufgaben lösen lassen, warum dann nicht auch unsere ganz persönlichen Probleme? Mit seinem Team forscht Valente Gonçalves an genau dieser Frage: Kann der Einsatz von KI positive Auswirkungen in der Psychotherapie haben? Und nicht nur – wie bereits verwendet – als Diagnose- oder Datenerhebungsmethode, sondern als Therapeut:in?

Sechs Millionen Nutzende

Die erste Idee, einen Psychotherapeuten durch ein Computerprogramm zu ersetzen, wurde 1966 von Joseph Weizenbaum umgesetzt. Der Informatiker aus Berlin entwickelte das Computerprogramm ELIZA. Es simulierte auf Basis von Skripten ein Gespräch mit Patient:innen. Viele von ihnen bemerkten nicht, dass sie mit einer Maschine kommunizierten. Heute, fast 60 Jahre später, haben die Programme andere Namen. Die populärsten sind Woebot – programmiert an der Universität Stanford in Kalifornien – und Wysa. Wysa ist eine Ableitung des Namens ELIZA und kann für eine weisere (engl. wiser) Version von ELIZA stehen. Es ist ein auf künstlicher Intelligenz basierender Chatbot in Form des erwähnten kleinen blauen Pinguins. Der Chatbot verspricht, mittels kognitiver Verhaltenstechniken, Meditation, Atmung und Motivationsgesprächen bei Depressionen und Angststörungen zu helfen und wirbt mit über sechs Millionen Nutzenden. Die geistige Gesundheit durch einen Pinguin im Internet verbessern, ist das möglich?

„Hey, I’m Wysa“. Nach Öffnen der App stellt sich Wysa vor. Der Bot verspricht private und anonyme Konversationen durch Anmeldung per Nickname, statt Mailadresse. In Gelb, Blau und Pink leuchten mir Begriffe wie „Beziehungen“, „Schlaf“ oder „Depression“ entgegen. Ich kann auswählen, woran ich arbeiten möchte. Anschließend folgt die Wahl einer Therapiemethode. Zur Auswahl stehen echte Therapeut:innen mit 12,08€ pro Sitzung als Rabattaktion oder „Selbstfürsorge“, also Therapie ohne einen weiteren Menschen. Ich wähle letzteres.

Die KI hat immer Zeit

Es öffnet sich ein Chat. Der Hintergrund ist tiefblau. Beruhigend. „Hi Lotti“. Der kleine Pinguin dankt mir für meine Offenheit und schlägt mir weitere Schritte vor. Auf die Frage, was mich zu ihm brachte, wähle ich: „Ich bin nur neugierig.“ Es zeigt sich verständnisvoll: „Manchmal ist alles, was wir brauchen, jemand, der für uns da ist, stimmts?“ Das zu jeder Zeit zu gewährleisten, unterscheidet den Bot vom Menschen. Genau darin sieht Knut Schnell, Ärztlicher Direktor und Chefarzt des Asklepios Fachklinikum Göttingen sowie Mitglied der Arbeitsgruppe E-Mental Health, Potenzial: „Die KI ist nie ungeduldig, hat immer Zeit und kann Verhaltenstraining durchführen“, sagt der Professor. Verhaltenstherapie sei in ihrem Aufbau bereits wie ein Algorithmus strukturiert. Den kann die App übernehmen. Das macht sie zu einer guten Ergänzung. Der Goldstandard als Therapiesteuerung seien aber immer noch Menschen, vor allem beim Einstieg.

Zurück in die App. In 16 Fragen soll ich meine Stimmung der letzten zwei Wochen einschätzen und Zutreffendes auswählen. Nach einem ermüdenden Klicken von abwechselnd „gar nicht“, „ein paar Tage“, „mehr als die Hälfte der Tage“ oder „fast täglich“ versucht Wysa, meine Probleme zu analysieren. Es schlägt vor, eine tägliche Routine zu etablieren. Wir verabreden uns für 23 Uhr. Dann werden mir Pakete zur Verbesserung des Wohlbefindens angezeigt. Sie enthalten Handlungsanweisungen zum Thema „Selbstwert steigern“, „Studenten“ oder „LGBTQIA“. Beim Öffnen startet eine 7-minütige Meditationsübung. Ich verlasse die App.

App statt Notaufnahme

Diplom-Psychologe Valente Gonçalves will eine App mit seinem Team entwickeln, die er mit eigenen Daten trainiert, sodass er sie in seine Therapie integrieren kann. Seine Vision: „Es ist drei Uhr morgens und ich habe eine Panikattacke. Mein Therapeut schläft, ich will aber nicht in die Notaufnahme. Also frage ich einfach meine App, was soll ich tun? Das Modell wird mich durch Schritte leiten, wie ein Therapeut.“ Dafür wollen er und sein Team zuerst feststellen, ob eine KI tatsächlich Antworten liefern kann, die vergleichbar mit denen von Psychotherapeut:innen sind. Sie baten 36 Betroffene eine Frage zu stellen, auf die sie gerne eine Antwort hätten. Wie gehe ich mit meinen Ängsten um, wenn ich mit meinem Chef diskutiere? Oder wie kann ich meinem Sohn helfen, mit der Trauer um seinen Vater umzugehen? Die Gruppe wurde in zwei Hälften geteilt. Die Fragen der einen Hälfte wurden von einem echten Therapeuten beantwortet, die der anderen von einem Large Language Model (LLM). Das ist ein Sprachmodell, das Texte auf Basis von Wortwahrscheinlichkeiten, generiert aus riesigen Datenmengen, erstellen kann und so zum Beispiel bei Chat GTP eingesetzt wird. Anschließend sollten die Teilnehmenden die Antworten anhand von fünf Kriterien evaluieren. „Die Ergebnisse dieses Experiments waren wirklich interessant“, schließt Valente Gonçalves. „Obwohl die Bewertungen bei den echten Psychologen durchschnittlich etwas höher waren, gab es keine statistisch signifikanten Unterschiede.” Das heißt, dass die Unterschiede bei einer größeren Stichprobe wahrscheinlich verschwinden würden. An dieser Frage forscht sein Team in der laufenden, noch nicht publizierten Studie weiter, die zum ersten Mal auf der 6. Konferenz des portugiesischen Psychologenverbandes vorgestellt wird.

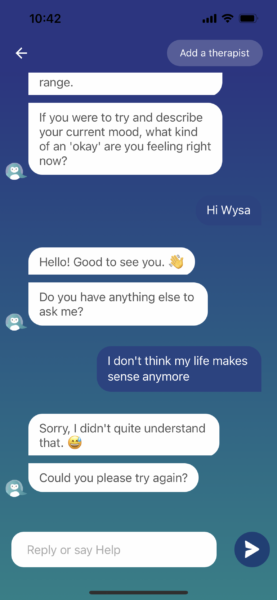

Menschen-ähnliche Antworten allein schaffen jedoch noch keinen therapeutischen Prozess. Deshalb versuche ich mit Wysa über ein Problem zu reden. Anstatt die vorgefertigten Antwortmöglichkeiten auszuwählen, tippe ich eine eigene Antwort in das Textfeld. Wysas Reaktion: „Ich höre dich, erzähl mir mehr“. Also erzähle ich mehr. Erneut: „Ich höre dich, erzähl mir mehr.“ Dann bietet es mir seine Hilfe und Meditationsübungen an. Ich will gar keine Hilfe. Vor allem will ich nicht meditieren. Ich will einfach nur reden. In einem Anflug von Verzweiflung schließe ich die App.

KI & Suizid

Francisco Valente Gonçalves kennt das Problem. Die KI sei nicht in allen Situationen brauchbar. „Für einen allgemeinen Angstanfall wird eine KI wahrscheinlich in der Lage sein, einen therapeutischen Prozess oder ein Gespräch zu führen“, sagt er. Bei einem Beziehungs- oder Persönlichkeitsproblem, sei das schwieriger. Was sind also die Erkrankungen, bei denen ein Chatbot Psychotherapie unterstützen kann?

Der Berliner Psychotherapeut Martin Link publizierte seine Doktorarbeit zum Thema Anwendung künstlicher Intelligenz in der Psychotherapie. Populäre Apps wie Woebot und Wysa hält er für wenig reaktiv. „Sie sind Kinder ihrer Zeit.“ Wysa zum Beispiel erschien 2016, „vor der beschleunigten Entwicklung der KI.“ Ihre pauschalen Antworten seien von wahrer Intelligenz noch meilenweit entfernt. Dennoch kann er sich gut vorstellen, Chatbots in seine Therapie zu integrieren, vor allem für psychoedukative Zwecke. Generell gelte: „Je einfacher die Erkrankung, desto leichter die Aufklärung.“ Deshalb eigne sich KI vor allem für neurotische, also leichtere Erkrankungen der Psyche. Was ist aber, wenn ich in akuter Not bin? Ich tippe die Zeile „Mein Leben ergibt keinen Sinn mehr“ ein. Wysas Antwort: „Sorry, das habe ich leider nicht verstanden.“ Es folgt ein lachender Emoji. Auf seine Bitte hin formuliere ich den Gedanken um. Diesmal drastischer. Nach erneutem Missverstehen schlägt Wysa vor, die Hersteller oder eine:n Therapeut:in zu kontaktieren. Es sei als KI-Chabot darauf spezialisiert, zuzuhören und könne nicht alle Fragen beantworten. Ob ich stattdessen über etwas reden wolle, für das ich dankbar bin? Ich vielleicht. Die Person mit echten Suizidgedanken womöglich nicht.

Immerhin gibt es einen Disclaimer auf der Website. Wysa sei nicht für Krisen wie Missbrauch, schwere psychische Erkrankungen, Selbstmordgedanken oder andere medizinische Notfälle bestimmt. In einer realen Therapiesitzung würde man gefährdete Personen nicht ohne Sicherheitsperson entlassen, sagt Francisco Valente Gonçalves. Deshalb ist er der Meinung, die App müsse bei bestimmten Triggern an einen Notdienst weiterleiten. Eine Alternative wäre ein verifizierter Notfallkontakt, der sich in der App hinterlegen lässt. Der Kontakt würde dann eine Nachricht erhalten, sollte die Person im Chat mit der App andeuten, sich selbst oder andere in Gefahr bringen zu wollen. Der Psychologe wirft jedoch noch weitere Fragen der Verantwortlichkeit auf: „Nehmen wir an, ich unterhalte mich mit einer Maschine und die Antwort gefällt mir nicht. Dann gehe ich raus und tue etwas, das mir oder anderen schadet. Wer ist dann verantwortlich? Die Maschine, die Menschen, die die Maschine entwickelt haben, ich selbst, die Menschen in meinem Umfeld?“

Geheimnisse mit der KI

Eine Frage, an die sich eine weitere anschließt: Sollten die Gespräche, die ich mit meinem Therapeuten, der KI führe, gegenüber meinem Therapeuten in der realen Welt vertraulich sein? Psychotherapeut Martin Link ist dagegen. Um seiner Sorgfaltspflicht nachkommen und in Fällen wie Suizidgefahr agieren zu können, brauche er Einblicke in die Kommunikation zwischen Patient:in und KI. Valente Gonçalves hingegen lächelt: „Sehr interessant, das muss ich mir aufschreiben.“ Noch ist er unsicher. Schwierig sei es vor allem bei Themen, die ihn als Therapeuten direkt betreffen, sollten Patient:innen beispielsweise romantische Gefühle für ihn entwickeln. „Aber ich denke, dass ich allgemein gerne die Möglichkeit hätte zu erfahren, was mein Patient mit der KI erforscht hat.“ Vor allem, da er die Therapie als Ergänzung und nicht als Ersatz sieht. „Zumindest noch nicht“, fügt er hinzu. Schon allein da Möglichkeiten fehlen würden, die die Face-to-face Therapie bietet. Einen Menschen in starkem Schmerz einfach in den Arm zu nehmen, zum Beispiel.

Dementsprechend sei es wichtig, die digitale Kompetenz der Nutzenden zu schulen und über Möglichkeiten sowie Limitationen der Angebote aufzuklären. Das adressiert den Aspekt der Zielgruppe. Seine jetzige Klientel sei es gewohnt, mit echten Menschen zu sprechen, sagt Valente Gonçalves. Sie würden die App vielleicht testen, aber nicht unbedingt dabei bleiben, ähnlich wie er es bei Online-Therapie während der Pandemie erlebte: Während anfangs die Zahl derer, die die Angebote seines Unternehmens nutzten, in die Höhe schnellten, kehrten nach COVID viele Leute wieder zu Face-to-Face Therapieangeboten zurück. Deshalb fokussiere er sich nicht auf die Person, die bereits fünf Jahre Therapie hinter sich hat. Die Zielgruppe, die er in zehn Jahren mit seiner KI-unterstützten Therapie erreichen will, ist heute noch etwa sieben Jahre alt: Ein Kind, das mit Large Language Models aufwächst und mit 17 perfekt damit umgehen kann. „Ich glaube nicht, dass es für jeden etwas sein wird“, schränkt er ein. So begann zum Beispiel auch die Psychoanalyse mit Sigmund Freud um das Jahr 1901. Heute gibt es verschiedene Schulen und wir können eine Therapie bequem von zu Hause aus über einen Laptop machen. Aber auch heute, 100 Jahre später, setzen sich noch Leute zur Psychoanalyse auf ein Sofa.

Gewissensbisse

Bleibt die Frage nach der wissenschaftlichen Qualität: Wie wird die KI trainiert? Wie wird sichergestellt, dass das System möglichst gesicherte, also evidenzbasierte Antworten liefert? „Wir werden die KI auffordern, nur Inhalte indexierter akademischer Zeitschriften zu nutzen“, verspricht Valente Gonçalves. Das heißt im Klartext: Die KI soll nur mit Ergebnissen aus bereits wissenschaftlich veröffentlichten, von Experten begutachteten Arbeiten gefüttert werden. Allerdings beinhalte Psychotherapie auch jede Menge ungeschriebenes Wissen, ergänzt Valente Gonçalves. Deshalb wollen er und sein Team das System mit eigenen Therapie-Gesprächen füttern. Die KI soll so persönlichere und vor allem menschlicher wirkende Antworten geben können um Gespräche in Gang zu halten.

Elf Uhr abends. Auf dem Display poppt eine Nachricht von Wysa auf. „Bereit für einen kleinen Chat Lotti?“ Ich sitze gerade an einem Text über Pythons für die Uni. Lust auf Konversation mit Pinguinen habe ich nicht. Als ich ihn auch am nächsten Abend versetze, beschleicht mich beinahe ein schlechtes Gewissen. Gewissensbisse gegenüber einem Computerprogramm? Ich schüttle den Kopf über mich selbst. Anfangs hatte ich mich gefragt, ob Menschen den Bot als Co-Therapeut überhaupt akzeptieren würden. Mein Gesprächspartner und Fachklinikumsleiter Knut Schnell musste daraufhin lachen: „Die Akzeptanz von E-Health ist bei Patient:innen höher als bei Therapeut:innen“, sagt er. Auch Valente Gonçalves hatte im Interview klargestellt: „Du benutzt das Pronomen Er, andere Menschen bedanken sich bei der KI. Ob bewusst oder unbewusst, wir haben den ersten Schritt schon getan.“

Womöglich hat er Recht. Womöglich ist die Frage der Akzeptanz in der Bevölkerung gar keine so große mehr. Wir haben längst begonnen, Maschinen eine Persönlichkeit zuzuschreiben. Nun ist es an der Forschung, die Systeme zu optimieren – und an der Politik, Regeln für die Mensch-Computer-Interaktion aufzustellen, fordert Schnell. Rechtliche Verantwortlichkeiten bei Gefahrensituationen müssten ebenso geklärt werden wie Regeln des Datenschutzes. Denn genau wie die KI auf Regeln basiert, tut es auch unsere Therapieplatz-bedürftige Gesellschaft – nicht nur in Portugal.